ChatGPT qanday ishlaydi? T9, oriq-semiz erkaklar, Barak Obama, transformer (1-qism)

Sun’iy intellekt, neyrotarmoqlar, ChatGPT... Ancha oldin paydo bo‘lgan (axborot texnologiyalari qarichi bilan o‘lchanganda) avvalgi ikkitasi haqida, garchi haminqadar qiziqish bo‘lsa-da, qandaydir tasavvurga ega edik. Biroq ChatGPT kelib hammasini o‘zgartirib yubordi... Diplom yozganmish, kelajakda odamlarni ishsiz qoldirarmish, endi nima bo‘ladi?.. Xullas, mish-mishlar bolalagan.

Vahimalar asoslimi? ChatGPTga o‘xshagan neyrotarmoqlar aynan sizni ishsiz qoldirishi mumkinmi? Umuman ular qanday ishlaydi? Bular haqida batafsil bilishni istaganlar uchun KATTA MAQOLA tayyorladik: qulayroq joylashib oling, ChatGPTga bag‘ishlangan uzun hikoyamizni boshlaymiz.

Hammasi T9dan boshlangan

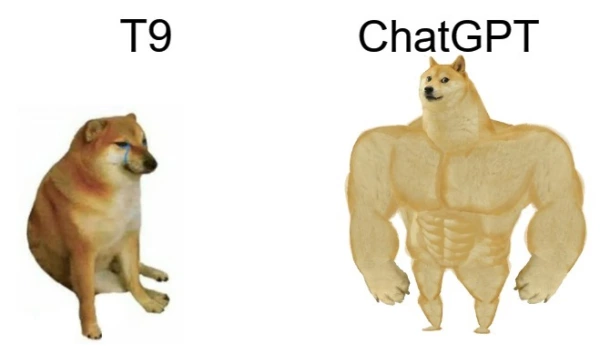

Eng oddiysidan boshlaymiz. Texnik nuqtai nazardan ChatGPT nimaligini tushunish uchun, avvalo, u nima emasligini aniq belgilab olishimiz kerak. U aqlli mavjudot emas, maktab o‘quvchisiga ham o‘xshamaydi (aqli va topshiriqlarni bajarish nuqtai nazaridan), alaloqibat, hamma narsani lahzada muhayyo qiluvchi jin ham emas. Juda oddiy: ChatGPT — hammamizning telefonimizda ishlab turgan T9, faqat juda kuchaytirilgani! Xuddi shunday: olimlar bu texnologiyalarning ikkisini ham “til modellari” (Language Models) deyishadi, bularning vazifasi matnda keyingi so‘z qanday kelishini taxmin qilishdan iborat, xolos.

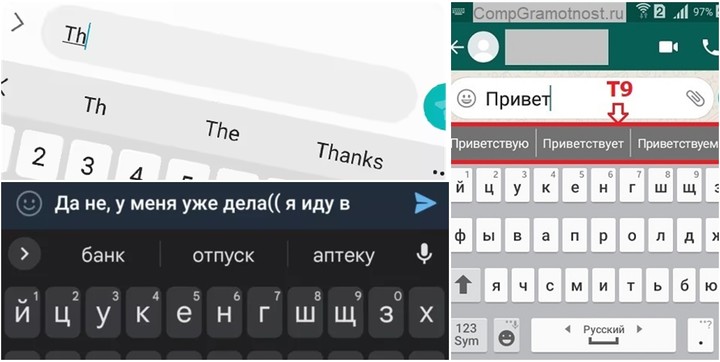

90-yillarning oxiridagi (o‘lmas-netmas Nokia 3210ga o‘xshagan) telefonlarda T9 original texnologiyasi keyingi so‘zni emas, balki joriy kiritishni taxmin qilish orqali tugmachali telefonlarda yozishni tezlashtirgandi. Texnologiya bir joyda turgani yo‘q, rivojlanishda davom etdi va 2010-yillarning boshlarida — smartfonlar davriga kelib, kontekst (oldingi so‘z)ni inobatga oladigan, tinish belgilarini qo‘yadigan va navbatdagi (keyingi) so‘zlarni taklif qiladigan bo‘ldi. Nihoyat, masalaning mohiyatiga yetib keldik: ta’bir joiz bo‘lsa, ChatGPT — T9/avtoalmashtirishning eng takomillashgan talqini!

Shunday qilib, smartfon klaviaturasidagi T9 ham, ChatGPT ham juda oddiy topshiriq — navbatdagi yagona so‘z qaysi bo‘lishini aniqlashga o‘rgatilgan. Tilli modellashtirish degani shu — bor matndan kelib chiqib keyin nima yozish kerakligi haqida xulosa chiqarish. Bunday bashorat qilish uchun esa til modellari, kontekstni davom ettirish maqsadida, u yoki bu so‘zlarning paydo bo‘lish ehtimollari ustida ishlashiga to‘g‘ri keladi. Tan oling, telefoningizdagi avtoto‘ldirish funksiyasi duch kelgan so‘zlarni bir xil ehtimollikda taklif qilaversa sizga yoqmaydi.

Smartfonimizdagi T9 yozilgan matnning davomida qaysi so‘zlar kelishini va qaysi so‘zlarni taklif qilishi bema’nilik ekanini yaxshi tushunadi. Qanday qilib? Savolga javob berish uchun eng oddiy neyrotarmoqlar qanday ishlashi haqida ozgina tasavvur berib o‘tamiz.

Neyrotarmoqlar so‘zlar ehtimolini qayerdan oladi?

Keling, yanayam oddiyroq savoldan boshlaymiz: ayrim narsalarning boshqalariga bog‘liqligini qanday taxmin qilish mumkin? Aytaylik, kompyuterni odamning vaznini uning bo‘yidan kelib chiqib aniqlashga o‘rgatmoqchimiz — bu vazifaga qanday yondashish kerak?

Birinchi navbatda, o‘zimizni qiziqtirgan bog‘liqliklarni qidirish uchun, ma’lumotlarni to‘plashimiz kerak (tushunish oson bo‘lishi uchun bir jins vakillari — bir necha ming nafar erkaklarning bo‘y/vazn statistikasini to‘playmiz), keyin ushbu ma’lumotlar ichidagi o‘xshash qidiruv uchun ba’zi matematik modellarni “o‘rgatish”ga harakat qilamiz.

Aniqlik uchun avvalo butun ma’lumotlar to‘plamini grafikda ifodalaymiz: gorizontal “X” o‘qida bo‘yni santimetrda, vertikal “Y” o‘qida esa vaznni ko‘rsatamiz.

Bir qarashdayoq muayyan qonuniyat ko‘zga tashlanadi: baland bo‘yli erkaklar, odatda, og‘irroq vaznli bo‘ladi. Bu bog‘liqlikni maktabning beshinchi sinfidan hammamizga tanish Y = k*X + b oddiy chiziqli tenglama shaklida ifodalash mumkin. Rasmda bizga kerakli chiziq “chiziqli regressiya” modeli yordamida aks etgan, u aslida k va b tenglama koeffitsiyentlarini shunday tanlash imkonini beradiki, natijada olingan chiziq bizning ma’lumotlarimizdagi asosiy bog‘liqlikni optimal tarzda tavsiflaydi (qiziqishga buni o‘zingizda ham sinab ko‘rishingiz, bo‘yingizni santimetrlarda kiritib, bu model vazniningizni qanchalik aniq topishiga amin bo‘lishingiz mumkin).

Ehtimol siz: “Xo‘p yaxshi, bo‘y/vazn masalasi shundoq ham tushunarli edi, lekin til neyrotarmoqlarining bunga nima aloqasi bor?", deyishingiz mumkin. Gap shundaki, neyrotarmoqlar — deyarli yuqoridagi kabi tenglamalar to‘plami, faqat ular ancha murakkab, qolayersa, matritsalardan foydalanadi.

Sodda qilib aytganda, xuddi shu T9 yoki ChatGPT — modelga kiritilgan oldingi so‘zlar (X) to‘plamiga qarab keyingi so‘zni (Y) bashorat qilishga harakat qiladigan aqlli tanlangan tenglamalar. Ma’lumotlar to‘plamida til modelini o‘rgatishdagi asosiy vazifa bu — iks (X)lar uchun shunday koeffitsiyentlarni tanlash kerakki, ular haqiqatan ham qandaydir bog‘liqlikni aks ettirsin (bizning bo‘y/vazn bo‘yicha misolimizdagi kabi). Katta modellar deganda biz juda juda katta parametr (ko‘rsatkich)larga ega bo‘lganlarini tushunamiz. Sun’iy intellekt sohasida ular aynan shunday ataladi — LLM, Large Language Models (Katta Til Modellari). Katta ko‘rsatkichli “semiz” modellar ajoyib matnlarni yozib beradi — hali bunga ham to‘xtalamiz.

Nega biz hadeb “navbatdagi so‘zni yozishni bashorat qilish” haqida gapirayapmiz-u, buyoqda ChatGPT so‘zlar uyoqda tursin, katta-katta matnlarni qalashtirib tashlayotgani haqida o‘ylayotgan bo‘lsangiz — demak, siz bekorga boshingizni qotirmayapsiz. Til modellari hech qiynalmay uzun matnlarni tuzadi, biroq ular aynan “so‘zma-so‘z” tamoyilida ishlaydi. Ya’ni har gal navbatdagi yangi so‘zni taqdim etishdan oldin, unga qo‘shib model avvalgi jami matnni elakdan o‘tkazadi va keyingina tayyor so‘zni oldingi mazmunga bog‘lab chiqarib beradi. Natijada bog‘liqlikka ega, mantiqan shakllangan matn paydo bo‘ladi.

“Barak” paradoksi yoki nima uchun til modellari ijodkor bo‘lishi kerak?

Aslida, tenglamalarimizda til modellari “igrek” sifatida aniq keyingi so‘zni emas, balki berilgan matnni davom ettirishi mumkin bo‘lgan ehtimoliy so‘zlarni taxmin qilishga urinadi. Nega? Nima uchun yagona “eng to‘g‘ri” so‘zni izlash mumkinmas? Keling, kichik o‘yin misolida ko‘rib chiqamiz.

Qoidalar quyidagicha: siz — til modelisiz (ChatGPT) va men sizdan “AQShning 44-prezidenti (va bu lavozimdagi birinchi afroamerikalik) Barak ...” matnini davom ettirishni so‘rayman. Ko‘p nuqta o‘rniga kerakli so‘zni qo‘ying!

Agar siz keyingi so‘z 100 foiz ehtimol bilan “Obama” bo‘lishini aytsangiz, “tabriklaymiz” — shu joyda xato qildingiz! Bu yerda gap yana bir mashhur Barak ... borligida emas, hammasi oddiy: rasmiy hujjatlarda prezidentning ismi ko‘pincha to‘liq yozilib, uning ikkinchi ismi (middle name) Husayn ekani ko‘rsatiladi. Shunday qilib, to‘g‘ri o‘qitilgan til modeli bizning jumlamizdagi keyingi so‘z “Obama” bo‘lishini faqat 90 foizlik shartli ehtimolda tutadi, qolgan 10 foizni esa matn “Husayn” qo‘shilgan holda davom etishiga asrab qo‘yadi (undan keyin Obama bo‘lishi ehtimoli esa deyarli 100 foizga teng).

Til modellarining juda qiziq jihatiga keldik: qarangki, ijodiy yondashuv ularga begona emas ekan! Darhaqiqat, har bir keyingi so‘zni yaratishda bunday modellar “tasodifiy” usulda, xuddi qur’a tashlagandek, tanlov qiladi. Ammo har qanday holatda ham emas, balki turli so‘zlarning “tushishi” ehtimoli model ichidagi tenglamalar bo‘yicha taklif qilgan ehtimolliklarga mos kelsagina (modelga turli matnlarning ulkan to‘plami kiritiladi).

Ma’lum bo‘lishicha, ayni model, xuddi odam kabi, hatto mutlaqo bir xil savollarga ham har xil javoblar berishi mumkin ekan. Umuman olganda, olimlar qachonlardir neyrotarmoqni har doim ehtimoliy yagona so‘zni tanlashga o‘rgatmoqchi bo‘lishgan — bir qarashda mantiqan asoslidek tuyulgani bilan, bu model amalda negadir yomon ishlaydi, lekin tasodifiylikning sog‘lom elementi ular uchun faqat foyda keltiradi (o‘zgaruvchanlikni va natijada javoblarning sifatini oshiradi).

Umuman olganda, bizning tilimiz (ba’zan) aniq qoidalar hamda istisnolardan iborat maxsus tuzilmadir. Gapdagi so‘zlar o‘z-o‘zidan paydo bo‘lmaydi, ular bir-biriga bog‘langan. Bu aloqalarni inson “avtomat rejimida” — ulg‘ayish davomida, maktab davrida, suhbatlar, mutolaa va boshqalarda yaxshi o‘rganadi. Shu bilan birga, odamlar ayni bir voqeani turli uslub va ohanglarda tasvirlashadi.

Tilning ushbu tavsifiy xususiyatlari yaxshi modellarda albatta ko‘zda tutilgan bo‘lishi shart. Model kontekstdagi nyuanslardan kelib chiqib so‘zlarning ehtimolini qanchalik aniqroq baholasa (matnning vaziyatni tavsiflovchi oldingi qismiga qarab), biz undan kutgan javoblarni shunchalik yaxshi hosil qila oladi.

Qisqacha ma’lumot: Maqolaning shu qismigacha biz oddiy til modellari smartfonlarning “T9/avtoto‘ldirish” funksiyalarida 2010-yillarning boshidan buyon foydalanilayotganiga aniqlik kiritdik. O‘z navbatida, ushbu modellar manba matniga qarab keyingi so‘zni bashorat qilish uchun katta hajmdagi ma’lumotlar o‘rgatilgan tenglamalar to‘plami hisoblanadi.

2018-yil: GPT-1 til modellarini o‘zgartiradi

Keling, almisoqdan qolgan T9 larni bir chetga surib, zamonaviyroq modellarga o‘tamiz: bugungi kunimizga jar solib kirib kelgan ChatGPT aynan GPT modellar oilasining eng yangi vakili sanaladi. Ammo u o‘z javoblari bilan odamlarni xursand qilish uchun qanday qilib bunday g‘ayrioddiy qobiliyatga ega bo‘lganini tushunish uchun yana moziyga qaytishimizga to‘g‘ri keladi.

GPT — qisqartma: Generative Pre-trained Transformer yoki “matn yaratish uchun o‘qitilgan transformer” degan ma’noni anglatadi. Transformer — olis 2017-yilda (“olis” deganimiz xato emas: ushbu sanoat mezonlariga ko‘ra, bosib bosib o‘tilgan olti yil — asrlarga teng) Google tadqiqotchilari tomonidan o‘ylab topilgan neyrotarmoq arxitekturasining nomidir.

Aynan Transformer ixtirosi shunchalik ahamiyatli bo‘lib chiqdiki, sun’iy intellekt (AI)ning barcha sohalari — matn tarjimalaridan tortib tasvir, ovoz yoki videoni qayta ishlashgacha, barchasida uni moslashtirish va qo‘llash jadallashib ketdi. Sun’iy intellekt sanoatiga tom ma’noda kuchli turtki berildi: “sun’iy intellekt qishi”dan yuqori sur’atli taraqqiyotga o‘tilib, turg‘unlikka barham berildi.

Konsepsiyaga ko‘ra, Transformer universal hisoblash mexanizmi bo‘lib, uni tasvirlash juda oson: u kirishda bir ketma-ketliklar to‘plami (ma’lumotlar)ni qabul qiladi va yana bir, biroq qandaydir algoritmga muvofiq o‘zgartirilgan, ketma-ketliklar to‘plamini chiqaradi. Matn, rasm va tovush (umuman, bu dunyodagi deyarli hamma narsani) raqamlar ketma-ketligi sifatida ifodalash mumkinligi sababli, Transformer yordamida deyarli har qanday vazifani uddalash mumkin.

Ammo Transformerning asosiy xususiyati uning qulayligi va moslashuvchanligidir: u kengaytirish juda oson oddiy modul-bloklardan iborat. Agar Transformergacha bo‘lgan eski til modellari, bir vaqtning o‘zida so‘zlarni juda ko‘p va tez “yutish”ga majburlansa, “tiqilib qolgan” (juda ko‘p resurs talab qilgan) bo‘lsa, neyrotarmoq-transformerlar bu vazifani ancha yaxshi uddalamoqda.

Dastlabki til modellari kiruvchi ma’lumotlarni “birin-ketin”, ya’ni ketma-ketlik asosida qayta ishlardi. Shuning uchun ham model bir sahifali katta matn bilan ishlayotganida, taxminan uchinchi xatboshining o‘rtalariga kelib, boshida nima bo‘lganini “unutib qo‘yardi”. Ammo Transformer qudratli — bir vaqtning o‘zida HAMMA narsaga qaray oladi, yanada qoyilmaqom natijalar berayotganining sababi ham shu.

Qisqacha ma’lumot: GPT-1 2018-yilda paydo bo‘ldi va neyrotarmoq orqali matnlarni yaratish uchun kattaroq hajm va samaradorlikka ega Transformer arxitekturasidan foydalanish mumkinligini isbotladi. Ya’ni kelajakda til modellarining hajmi va murakkabligini oshirish uchun katta zaxira yaratildi.

(Davomi bu yerda)

Izoh qoldirish uchun saytda ro'yxatdan o'ting

Kirish

Ijtimoiy tarmoqlar orqali kiring

FacebookTwitter