ChatGPT қандай ишлайди? Етти мингта Шекспир, оч балиқлар ва математика (2-қисм)

Сунъий интеллект, нейротармоқлар, ChatGPT ҳақидаги КАТТА МАҚОЛАнинг давоми.

(1-қисм: ChatGPT қандай ишлайди? T9, ориқ-семиз эркаклар, Барак Обама, трансформер)

2019 йил: GPT-2 ёхуд етти мингта Шекспирни тил моделига қандай жойлаш мумкин?

Aгар нейротармоқни расмларни таниб олишга ўргатмоқчи бўлсангиз, шунчаки “мана сенга 100 500 та табиат ва турли маҳсулотларнинг улкан архивига ҳавола, керак бўлса, тартибла!”, дея олмайсиз. Моделни ўргатиш учун аввал ўқув маълумотлари тўпламини белгилашингиз керак — яъни ҳар бир фотосуратни унинг хусусиятларини билдирувчи сўзлар билан бойитишингиз талаб этилади (масалан, ёзилиши, айтилиши бир хил, аммо ҳар хил маъноли сўзлар бор).

Тил моделларини ўргатишнинг ажойиблиги нимада, биласизми? Уларни мутлақо ҳар хил матнли маълумотлар билан “озиқлантириш” мумкин ва бу маълумотларни олдиндан махсус белгилаш керак эмас. Бу худдики мактаб ўқувчисини, унинг олдига турли китоблар тўла жомадонни қўйиб, ҳеч қандай кўрсатма бермасдан, ўқишни қайси биридан бошлашни айтмасдан ўқитишга ўхшайди — тил моделининг ўзи ўқиб, шу жараёнда керакли билимларни орттириб бораверади!

Демак, биз тил моделини ўзидан олдинги сўзлар ҳақидаги маълумотларга асосланиб, кейинги сўзни башорат қилишга ўргатмоқчимиз, тўғрими? Инсон томонидан қачонлардир ёзилган ҳар қандай матн — унинг учун тайёр дарслик маълумоти ҳисобланади. Чунки у аллақачон “баъзи сўзлар ва жумлалар тўплами” кетма-кетликларини ўзида жамлашга улгурган.

Келинг, GPT-1да синовдан ўтган Трансформерлар технологияси масштаблашиш нуқтаи назаридан жуда муваффақиятли бўлганини яна бир бор эслаймиз: у катта ҳажмдаги маълумотлар ва “массив” моделлар (кўп сонли параметрлардан иборат) билан аждодларига қараганда анча самарали ишлай олади. 2019 йилда OpenAI олимлари ҳам шундай хулосага келишди: “Улкан тил моделларини яратиш фурсати келди!”

Умуман олганда, GPT-2ни иккита асосий йўналишда — машғулот маълумотлари тўплами (датасет) ва модел ўлчами (кўрсаткичлар сони) тубдан янгилашга қарор қилинди.

Ўша пайтда тил моделларини ўргатиш учун махсус, катта, юқори сифатли, очиқ матнли маълумотлар тўплами йўқ эди. Шундай шароитда OpenAI ходимлари оқилона чора қўллашди: энг оммалашган инглиззабон онлайн-форум — Redditга кириб, учтадан кўп “лайк” тўплаган барча постлардаги гиперҳаволаларни кўчириб олишди (ҳазил эмас, буям илмий ёндашув!). Якунда ҳаммаси бўлиб 8 миллионга яқин ҳаволалар тўпланди, жами юклаб олинган матнлар “оғирлиги” 40 гигабайтни ташкил этди.

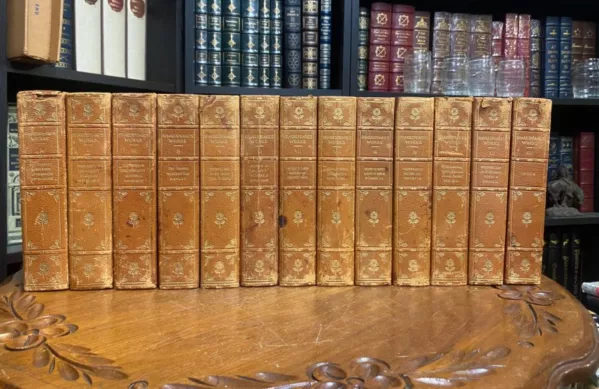

Хўш, бу кўпми ёки озми? Келинг солиштирамиз: Уилям Шекспирнинг сайланма асарлари (барча пьесалари, сонет ва шеърлари) 850 000 та сўздан иборат. Китобнинг бир саҳифасига ўртача 300 тадан инглизча сўз жойлашади — шу тахлит буюк инглиз адиби қаламига мансуб асарлар тахминан 2 800 саҳифа бўлади. Ана шунча саҳифадаги матнлар компютерда 5,5 мегабайт хотирани эгаллайди. Ёки GPT-2ни ўқитиш учун Reddit орқали тўпланган матнлар тўплами (40 Гб)дан 7 300 баравар кам...

Бир одам дақиқасига ўртача бир саҳифа ўқий олади. Ҳатто суткасига 24 соатлаб фақат мутолаага сарфлаган (овқатланмай ва ухламай) тақдирингизда ҳам заковат бобида GPT-2га етишингиз учун камида 40 йил керак бўлади!

Машғулот маълумотлари ҳажми билан иш битмайди. Беш яшар болани Шекспирни такрор-такрор мутолаа қилишга мажбурлаб, камига квант физикаси маърузаларини тинмай қулоғига қуйган билан ақлли бўлиб қолмайди. Бунда ҳам шу: тил модели улкан маълумотларни “ямламай юта олиши” учун аввало мураккаб ва сиғимдор бўлиши шарт. Хўш, бу мураккаблик қандай ўлчанади, нималарда кўзга ташланади?

Тил моделлари дунёсида нега Plus Size моделлари кўпроқ қадрланади?

Хотирангиздан кўтарилмаган бўлса, юқорида тил моделлари ичида Y=k*X+b кўринишидаги тенгламалар мавжудлигини айтдик, бу ерда қидирилаётган игрек (Y) — биз башорат қилишга уринаётган навбатдаги сўз, икс (х)лар эса киришдаги сўзлар — улардан келиб чиқиб биз башоратни амалга оширамиз.

Хўш, нима деб ўйлайсиз: 2019 йилда энг катта GPT-2 моделини тавсифловчи тенгламада нечта параметр бор эди? Юз мингта ёки бир неча миллионтами? Юқорироқни нишонга олаверинг: формулада нақ бир ярим миллиард (1 500 000 000) параметр бор эди. Шунча рақамни файлга ёзиб, компютерингизда сақласангиз ҳам, у 6 гигабайт жойни эгаллайди! Бир томондан, бу моделдаги матнли маълумотлар массиви (Reddit орқали тўпланган 40 Гб)дан анча кам. Иккинчи томондан, модел ушбу матнни тўлиқ эслаб қолиши шарт эмас, одамлар томонидан ёзилган матнлардан ажратилиши мумкин бўлган баъзи боғлиқликлар (паттернлар, қоидалар)ни топса кифоя.

Ушбу параметрлар (уларни “оғирлик” ёки “коэффициентлар” ҳам дейишади) моделни ўқитиш жараёнида олинади, кейин сақланади ва бошқа ўзгармайди. Яъни, моделдан фойдаланилганда, бу улкан тенгламада ҳар сафар турли “х”лар алмаштирилади (кириш матнидаги сўзлар), лекин тенглама параметрлари (“х”лардаги “k” сонли коэффициентлари) ўзгаришсиз қолади.

Моделга қанчалик мураккаб тенглама ўрнатилган бўлса (яъни параметрлари қанчалик кўп бўлса), у эҳтимолликни шунча яхшироқ ва ҳақиқатга яқинроқ башорат қилади. GPT-2 моделидан бошлаб матнлар шу қадар яхши чиқишни бошладики, OpenAI тадқиқотчилари, хавфсизлик нуқтаи назаридан, моделни очиқ ишга туширишдан ҳам чўчиб қолишди.

Чиндан ҳам улкан “сифатли сакраш” эди! Ёдингизда бўлса, T9/GPT-1 моделлари нари борса СМС-хабарни ёзишда навбатдаги сўзни танлашда тавсия беришдан бошқасига ярамас эди. GPT-2 эса юқори синф ўқувчиси даражасида иншо ёза олади! Унга “Иқлим ўзгаришига ижобий таъсир кўрсатиш учун қандай фундаментал иқтисодий ва сиёсий ўзгаришлар талаб этилади?” мавзусида иншо ёздиришди. Иншони тахаллус остида тегишли танловнинг ҳакамлар ҳайъатига юборишганида, улар ҳеч нарсани пайқашмади. Албатта, иншо жуда юқори баҳоланмади, ғолиб бўлмади. Аммо, “қандай бемаъни нарсани юбордингиз!”, — деган жавоб ҳам келмади.

“Иншо саводли ёзилган, далиллар мисоллар билан мустаҳкамланган, бироқ ғоя янгилик эмас”.

Ҳакамлардан бири GPT-2 ёзган иншони шундай баҳолади.

Миқдорнинг сифатга ўзгариши

Умуман олганда, модел ҳажми катталашиб боргани сайин унинг сифатли янги хусусиятлари очилиб бориши ҳайратланарли. Келинг, GPT-2 ўзлаштирган кўникмаларни батафсилроқ кўриб чиқамиз.

Матндаги иккимаъноликларни ҳал этиш учун махсус топшириқлар тўплами бор, улар матнни тўғри тушунишда ёрдам беради. Масалан, иккита гапни солиштиринг:

- Балиқ ўлжани ютди. У мазали эди.

- Балиқ ўлжани ютди. У оч эди.

Биринчи мисолдаги “у” олмоши қайси объектга тегишли — балиқгами ёки ўлжага? Иккинчи ҳолатдачи? Кўпчилик контекстдан осонгина тушунади, бир ҳолатда “у” ўлжа, бошқа ҳолатда эса балиқ. Aммо буни тушуниш учун сиз шунчаки жумлани ўқибгина қолмай, балки ҳолат расмини хаёлан чизиб кўришингиз керак! Масалан, балиқ турли вазиятларда ҳам оч, ҳам мазали (пиширилиб, ликопчада турганида) бўлиши мумкин.

Одамлар бу каби топшириқларни 95 фоиз ҳолатда тўғри ечишади, аммо илк тил моделлари бу жумбоқни 50/50 ҳолатда таваккалига топган, холос.

Эҳтимол, шунча қийналиб ўтирмай, жавобларга эга катта маълумотлар базасини (бир неча минг мисоллар билан) тўплаб, нейротармоқ шуларни топишга ўргатилса кифояку, дейишингиз ҳам мумкин. Эски моделларда шундай ҳам қилишган, аммо улар 60 фоизлик муваффақият чегарасидан нарига ўта олмади. GPT-2ни эса ҳеч ким бунақа фокусларга ўргатмаганди, у эса кутилмаганда “ихтисослашган” аждодларини ҳам доғда қолдириб, оч балиқларни 70 фоиз аниқликда топишни мустақил ўрганиб олди!

Миқдорнинг сифатга ўзгариши шу бўлади. Қизиғи, параметрлар сонининг уч бараварга — 115 миллиондан 350 миллионгача кўпайиши билан модел “балиқ” муаммосини аниқ ҳал этишида жиддий ижобий силжиш деярли сезилмайди, бироқ модел ўлчами яна икки баравар катталаштирилса — 700 млн параметрга етказилса, сифатли сакраш юз беради, тил модели ўзи махсус ўргатилмаган мутлақо нотаниш топшириқларни ҳам аъло даражада уддалай олиши ҳайратга солишни бошлайди.

Қисқача маълумот: GPT-2 2019 йилда чиқарилган, ўзидан олдинги моделга нисбатан ўқув матни маълумотлари ҳажми ҳамда моделнинг ўлчами (параметрлар сони) 10 баравар оширилган. Бундай миқдорий ўсиш натижасида модел фавқулодда сифатли ва янги кўникмаларга эга бўлди: узун ва тугал маъноли иншолар ёзишдан тортиб дунёқарашни белгиловчи мураккаб топшириқларни ечишга ўтди.

2020 йил: GPT-3

GPT-2ни “семиртириш” (ва ақллироқ қилиш) билан бир муддат оворагарчиликлардан сўнг OpenAI шоввозлари ўйлаб қолишди: “Моделни янаям катталаштирсак нима бўлади? Дейлик, 100 баробарга”. Шу тариқа 2020 йилда навбатдаги талқин — GPT-3 дунёга келди. У олдингисига нисбатан 116 баравар кўп — 175 миллиард кўрсаткичлари мақтана оларди! Нейротармоқнинг ўзи эса ақл бовар қилмас 700 гигабайт тош босарди!

GPT-3ни ўқитиш учун маълумотлар тўплами янам кенгайди: тахминан 10 бараварга ошиб, 420 гигабайт қўшилди — саноқсиз китоблар, Википедия ва турли интернет сайтларидан олинган матнлар жойланди. Шунчаликки, энди бунча ҳажмдаги маълумотни ўқиб тушуниш учун ўнлаб одамларга 50 йил тинмай ўқиш ҳам камлик қиларди.

Қизиқарли нюанс дарҳол эътиборни тортади: GPT-2дан фарқли ўлароқ, GPT-3 (700 Гб) энди ўзи ўқиб ўрганаётган маълумотлар тўплами (420 Гб)дан катталашиб кетганди. Бу эса парадоксни келтириб чиқаради: бизнинг “нейромия”, хом маълумотларни ўрганиш жараёнида, ўзига берилган дастлабки маълумотдан-да каттароқ ҳажмдаги маълумотни ҳосил қилади.

Бундай умумлаштириш (“маънолаштириш”) аввалгисидан ҳам афзалроқ экстраполяция имконини беради, яъни моделни ўқитишда кам учраган ёки умуман учрамаган матнларни яратишда яхши натижалар кўрсатади. Энди моделни муайян вазифани ечишга ўргатиш шарт бўлмай қолди — ўрнига топшириқ сўзлар билан таърифланиб, бир нечта мисоллар келтирилса кифоя, ўзидан нима талаб қилинаётганини англаган GPT-3 бу ёғини ўзи бажара оларди!

Яна шуниси ойдинлашдики, ҳеч ким “тор доирадаги” вазифаларни ўргатмаган GPT-3 қиёфасидаги “универсал Халк” ўзигача мавжуд бўлган ихтисослашган моделларнинг курагини осонгина ерга теккизишни бошлади. Масалан, фақат таржима учун мўлжалланган нейротармоқлар бор, GPT-3 француз ёки немисчадан инглиз тилига таржимани уларга нисбатан яхшироқ ва тезроқ бажаришни бошлади. Қанақасига? Ҳеч ким ўргатмаса ҳам GPT-3 қандай қилиб тилмоч бўлиб олди? Ҳаммаси оддий, GPT-3 — лингвистик модел, вазифаси фақат навбатдаги сўзни тўғри топишдан иборат. Шу.

Бу ҳали ҳолва. GPT-3 математикани мустақил ўрганиб олганига нима дейсиз?!

Ўзингиз ўйланг: тил модели матнларни сўзлар билан давом эттиришга ўргатилганди, у эса, масалан, “378 + 789 =” ёзилса айнан “1167” деб давом эттириб кетмоқда, бошқача эмас! Математикани ўзи ўрганиб олди. Ахир бу мўъжиза эмасми?!

Aйтганча, GPT-2ни қийнаган “оч балиқ” жумбоғини GPT-3 худди одам каби 90 фоиздан юқори аниқликда топишни ҳам ўрганиб олди. Шу ўринда савол туғилади: унинг ҳажми яна 100 баравар оширилса нима бўлади? Дейлик, ўнлаб триллион кўрсаткичлар қўшилса...

Келинг, шу ерда кичик чекиниш қилиб, “модел вазифаларни бажара олади”, дегани нималигига аниқлик киритиб олсак. Моҳиятан жараён қуйидагича: моделга қандайдир сўров матнини киритамиз, у эса ўз таклифи билан уни тўлдиради. Агар бу давом (генерация) биз кутганимиз билан мос келса, демак, модел ўзига берилган вазифани уддалаган бўлади.

Биз киритадиган матн промпт деб аталади. Нимани хоҳлаётганимизни қанчалик аниқ тасвирласак, модел нима қилиш кераклигини яхшироқ тушунади. Агар сўровга ўнлаб мисолларни қўшиб берсак, натижаси кутганимиздан ҳам аъло бўлади!

(Давоми бу ерда)

Изоҳ қолдириш учун сайтда рўйхатдан ўтинг

Кириш

Ижтимоий тармоқлар орқали киринг

FacebookTwitter