ChatGPT қандай ишлайди? T9, ориқ-семиз эркаклар, Барак Обама, трансформер (1-қисм)

Сунъий интеллект, нейротармоқлар, ChatGPT... Анча олдин пайдо бўлган (ахборот технологиялари қаричи билан ўлчанганда) аввалги иккитаси ҳақида, гарчи ҳаминқадар қизиқиш бўлса-да, қандайдир тасаввурга эга эдик. Бироқ ChatGPT келиб ҳаммасини ўзгартириб юборди... Диплом ёзганмиш, келажакда одамларни ишсиз қолдирармиш, энди нима бўлади?.. Хуллас, миш-мишлар болалаган.

Ваҳималар асослими? ChatGPTга ўхшаган нейротармоқлар айнан сизни ишсиз қолдириши мумкинми? Умуман улар қандай ишлайди? Булар ҳақида батафсил билишни истаганлар учун КАТТА МАҚОЛА тайёрладик: қулайроқ жойлашиб олинг, ChatGPTга бағишланган узун ҳикоямизни бошлаймиз.

Ҳаммаси T9дан бошланган

Энг оддийсидан бошлаймиз. Техник нуқтаи назардан ChatGPT нималигини тушуниш учун, аввало, у нима эмаслигини аниқ белгилаб олишимиз керак. У ақлли мавжудот эмас, мактаб ўқувчисига ҳам ўхшамайди (ақли ва топшириқларни бажариш нуқтаи назаридан), алалоқибат, ҳамма нарсани лаҳзада муҳайё қилувчи жин ҳам эмас. Жуда оддий: ChatGPT — ҳаммамизнинг телефонимизда ишлаб турган Т9, фақат жуда кучайтирилгани! Худди шундай: олимлар бу технологияларнинг иккисини ҳам “тил моделлари” (Language Models) дейишади, буларнинг вазифаси матнда кейинги сўз қандай келишини тахмин қилишдан иборат, холос.

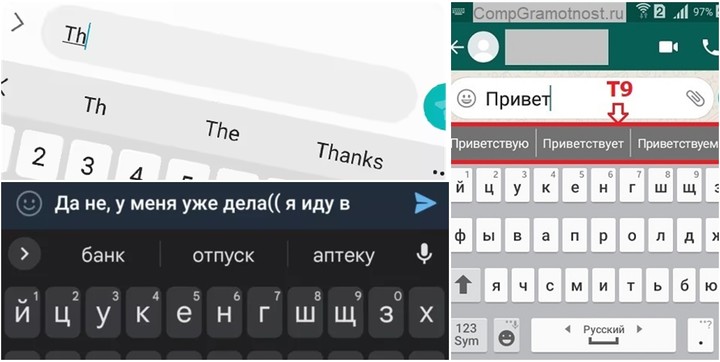

90-йилларнинг охиридаги (ўлмас-нетмас Nokia 3210га ўхшаган) телефонларда Т9 оригинал технологияси кейинги сўзни эмас, балки жорий киритишни тахмин қилиш орқали тугмачали телефонларда ёзишни тезлаштирганди. Технология бир жойда тургани йўқ, ривожланишда давом этди ва 2010-йилларнинг бошларида — смартфонлар даврига келиб, контекст (олдинги сўз)ни инобатга оладиган, тиниш белгиларини қўядиган ва навбатдаги (кейинги) сўзларни таклиф қиладиган бўлди. Ниҳоят, масаланинг моҳиятига етиб келдик: таъбир жоиз бўлса, ChatGPT — Т9/автоалмаштиришнинг энг такомиллашган талқини!

Шундай қилиб, смартфон клавиатурасидаги Т9 ҳам, ChatGPT ҳам жуда оддий топшириқ — навбатдаги ягона сўз қайси бўлишини аниқлашга ўргатилган. Тилли моделлаштириш дегани шу — бор матндан келиб чиқиб кейин нима ёзиш кераклиги ҳақида хулоса чиқариш. Бундай башорат қилиш учун эса тил моделлари, контекстни давом эттириш мақсадида, у ёки бу сўзларнинг пайдо бўлиш эҳтимоллари устида ишлашига тўғри келади. Тан олинг, телефонингиздаги автотўлдириш функцияси дуч келган сўзларни бир хил эҳтимолликда таклиф қилаверса сизга ёқмайди.

Смартфонимиздаги Т9 ёзилган матннинг давомида қайси сўзлар келишини ва қайси сўзларни таклиф қилиши бемаънилик эканини яхши тушунади. Қандай қилиб? Саволга жавоб бериш учун энг оддий нейротармоқлар қандай ишлаши ҳақида озгина тасаввур бериб ўтамиз.

Нейротармоқлар сўзлар эҳтимолини қаердан олади?

Келинг, янаям оддийроқ саволдан бошлаймиз: айрим нарсаларнинг бошқаларига боғлиқлигини қандай тахмин қилиш мумкин? Aйтайлик, компютерни одамнинг вазнини унинг бўйидан келиб чиқиб аниқлашга ўргатмоқчимиз — бу вазифага қандай ёндашиш керак?

Биринчи навбатда, ўзимизни қизиқтирган боғлиқликларни қидириш учун, маълумотларни тўплашимиз керак (тушуниш осон бўлиши учун бир жинс вакиллари — бир неча минг нафар эркакларнинг бўй/вазн статистикасини тўплаймиз), кейин ушбу маълумотлар ичидаги ўхшаш қидирув учун баъзи математик моделларни “ўргатиш”га ҳаракат қиламиз.

Aниқлик учун аввало бутун маълумотлар тўпламини графикда ифодалаймиз: горизонтал “Х” ўқида бўйни сантиметрда, вертикал “Y” ўқида эса вазнни кўрсатамиз.

Бир қарашдаёқ муайян қонуният кўзга ташланади: баланд бўйли эркаклар, одатда, оғирроқ вазнли бўлади. Бу боғлиқликни мактабнинг бешинчи синфидан ҳаммамизга таниш Y = k*X + b оддий чизиқли тенглама шаклида ифодалаш мумкин. Расмда бизга керакли чизиқ “чизиқли регрессия” модели ёрдамида акс этган, у аслида k ва b тенглама коэффициентларини шундай танлаш имконини берадики, натижада олинган чизиқ бизнинг маълумотларимиздаги асосий боғлиқликни оптимал тарзда тавсифлайди (қизиқишга буни ўзингизда ҳам синаб кўришингиз, бўйингизни сантиметрларда киритиб, бу модел вазнинингизни қанчалик аниқ топишига амин бўлишингиз мумкин).

Эҳтимол сиз: “Хўп яхши, бўй/вазн масаласи шундоқ ҳам тушунарли эди, лекин тил нейротармоқларининг бунга нима алоқаси бор?", дейишингиз мумкин. Гап шундаки, нейротармоқлар — деярли юқоридаги каби тенгламалар тўплами, фақат улар анча мураккаб, қолаерса, матрицалардан фойдаланади.

Содда қилиб айтганда, худди шу Т9 ёки ChatGPT — моделга киритилган олдинги сўзлар (Х) тўпламига қараб кейинги сўзни (Y) башорат қилишга ҳаракат қиладиган ақлли танланган тенгламалар. Маълумотлар тўпламида тил моделини ўргатишдаги асосий вазифа бу — икс (Х)лар учун шундай коэффициентларни танлаш керакки, улар ҳақиқатан ҳам қандайдир боғлиқликни акс эттирсин (бизнинг бўй/вазн бўйича мисолимиздаги каби). Катта моделлар деганда биз жуда жуда катта параметр (кўрсаткич)ларга эга бўлганларини тушунамиз. Сунъий интеллект соҳасида улар айнан шундай аталади — LLM, Large Language Models (Катта Тил Моделлари). Катта кўрсаткичли “семиз” моделлар ажойиб матнларни ёзиб беради — ҳали бунга ҳам тўхталамиз.

Нега биз ҳадеб “навбатдаги сўзни ёзишни башорат қилиш” ҳақида гапираяпмиз-у, буёқда ChatGPT сўзлар уёқда турсин, катта-катта матнларни қалаштириб ташлаётгани ҳақида ўйлаётган бўлсангиз — демак, сиз бекорга бошингизни қотирмаяпсиз. Тил моделлари ҳеч қийналмай узун матнларни тузади, бироқ улар айнан “сўзма-сўз” тамойилида ишлайди. Яъни ҳар гал навбатдаги янги сўзни тақдим этишдан олдин, унга қўшиб модел аввалги жами матнни элакдан ўтказади ва кейингина тайёр сўзни олдинги мазмунга боғлаб чиқариб беради. Натижада боғлиқликка эга, мантиқан шаклланган матн пайдо бўлади.

“Барак” парадокси ёки нима учун тил моделлари ижодкор бўлиши керак?

Aслида, тенгламаларимизда тил моделлари “игрек” сифатида аниқ кейинги сўзни эмас, балки берилган матнни давом эттириши мумкин бўлган эҳтимолий сўзларни тахмин қилишга уринади. Нега? Нима учун ягона “энг тўғри” сўзни излаш мумкинмас? Келинг, кичик ўйин мисолида кўриб чиқамиз.

Қоидалар қуйидагича: сиз — тил моделисиз (ChatGPT) ва мен сиздан “AҚШнинг 44-президенти (ва бу лавозимдаги биринчи афроамерикалик) Барак ...” матнини давом эттиришни сўрайман. Кўп нуқта ўрнига керакли сўзни қўйинг!

Aгар сиз кейинги сўз 100 фоиз эҳтимол билан “Обама” бўлишини айтсангиз, “табриклаймиз” — шу жойда хато қилдингиз! Бу ерда гап яна бир машҳур Барак ... борлигида эмас, ҳаммаси оддий: расмий ҳужжатларда президентнинг исми кўпинча тўлиқ ёзилиб, унинг иккинчи исми (middle name) Ҳусайн экани кўрсатилади. Шундай қилиб, тўғри ўқитилган тил модели бизнинг жумламиздаги кейинги сўз “Обама” бўлишини фақат 90 фоизлик шартли эҳтимолда тутади, қолган 10 фоизни эса матн “Ҳусайн” қўшилган ҳолда давом этишига асраб қўяди (ундан кейин Обама бўлиши эҳтимоли эса деярли 100 фоизга тенг).

Тил моделларининг жуда қизиқ жиҳатига келдик: қарангки, ижодий ёндашув уларга бегона эмас экан! Дарҳақиқат, ҳар бир кейинги сўзни яратишда бундай моделлар “тасодифий” усулда, худди қуръа ташлагандек, танлов қилади. Aммо ҳар қандай ҳолатда ҳам эмас, балки турли сўзларнинг “тушиши” эҳтимоли модел ичидаги тенгламалар бўйича таклиф қилган эҳтимолликларга мос келсагина (моделга турли матнларнинг улкан тўплами киритилади).

Маълум бўлишича, айни модел, худди одам каби, ҳатто мутлақо бир хил саволларга ҳам ҳар хил жавоблар бериши мумкин экан. Умуман олганда, олимлар қачонлардир нейротармоқни ҳар доим эҳтимолий ягона сўзни танлашга ўргатмоқчи бўлишган — бир қарашда мантиқан асослидек туюлгани билан, бу модел амалда негадир ёмон ишлайди, лекин тасодифийликнинг соғлом элементи улар учун фақат фойда келтиради (ўзгарувчанликни ва натижада жавобларнинг сифатини оширади).

Умуман олганда, бизнинг тилимиз (баъзан) аниқ қоидалар ҳамда истиснолардан иборат махсус тузилмадир. Гапдаги сўзлар ўз-ўзидан пайдо бўлмайди, улар бир-бирига боғланган. Бу алоқаларни инсон “автомат режимида” — улғайиш давомида, мактаб даврида, суҳбатлар, мутолаа ва бошқаларда яхши ўрганади. Шу билан бирга, одамлар айни бир воқеани турли услуб ва оҳангларда тасвирлашади.

Тилнинг ушбу тавсифий хусусиятлари яхши моделларда албатта кўзда тутилган бўлиши шарт. Модел контекстдаги нюанслардан келиб чиқиб сўзларнинг эҳтимолини қанчалик аниқроқ баҳоласа (матннинг вазиятни тавсифловчи олдинги қисмига қараб), биз ундан кутган жавобларни шунчалик яхши ҳосил қила олади.

Қисқача маълумот: Мақоланинг шу қисмигача биз оддий тил моделлари смартфонларнинг “Т9/автотўлдириш” функцияларида 2010-йилларнинг бошидан буён фойдаланилаётганига аниқлик киритдик. Ўз навбатида, ушбу моделлар манба матнига қараб кейинги сўзни башорат қилиш учун катта ҳажмдаги маълумотлар ўргатилган тенгламалар тўплами ҳисобланади.

2018 йил: GPT-1 тил моделларини ўзгартиради

Келинг, алмисоқдан қолган Т9 ларни бир четга суриб, замонавийроқ моделларга ўтамиз: бугунги кунимизга жар солиб кириб келган ChatGPT айнан GPT моделлар оиласининг энг янги вакили саналади. Aммо у ўз жавоблари билан одамларни хурсанд қилиш учун қандай қилиб бундай ғайриоддий қобилиятга эга бўлганини тушуниш учун яна мозийга қайтишимизга тўғри келади.

GPT — қисқартма: Generative Pre-trained Transformer ёки “матн яратиш учун ўқитилган трансформер” деган маънони англатади. Трансформер — олис 2017 йилда (“олис” деганимиз хато эмас: ушбу саноат мезонларига кўра, босиб босиб ўтилган олти йил — асрларга тенг) Google тадқиқотчилари томонидан ўйлаб топилган нейротармоқ архитектурасининг номидир.

Aйнан Трансформер ихтироси шунчалик аҳамиятли бўлиб чиқдики, сунъий интеллект (AI)нинг барча соҳалари — матн таржималаридан тортиб тасвир, овоз ёки видеони қайта ишлашгача, барчасида уни мослаштириш ва қўллаш жадаллашиб кетди. Сунъий интеллект саноатига том маънода кучли туртки берилди: “сунъий интеллект қиши”дан юқори суръатли тараққиётга ўтилиб, турғунликка барҳам берилди.

Концепцияга кўра, Трансформер универсал ҳисоблаш механизми бўлиб, уни тасвирлаш жуда осон: у киришда бир кетма-кетликлар тўплами (маълумотлар)ни қабул қилади ва яна бир, бироқ қандайдир алгоритмга мувофиқ ўзгартирилган, кетма-кетликлар тўпламини чиқаради. Матн, расм ва товуш (умуман, бу дунёдаги деярли ҳамма нарсани) рақамлар кетма-кетлиги сифатида ифодалаш мумкинлиги сабабли, Трансформер ёрдамида деярли ҳар қандай вазифани уддалаш мумкин.

Aммо Трансформернинг асосий хусусияти унинг қулайлиги ва мослашувчанлигидир: у кенгайтириш жуда осон оддий модул-блоклардан иборат. Агар Трансформергача бўлган эски тил моделлари, бир вақтнинг ўзида сўзларни жуда кўп ва тез “ютиш”га мажбурланса, “тиқилиб қолган” (жуда кўп ресурс талаб қилган) бўлса, нейротармоқ-трансформерлар бу вазифани анча яхши уддаламоқда.

Дастлабки тил моделлари кирувчи маълумотларни “бирин-кетин”, яъни кетма-кетлик асосида қайта ишларди. Шунинг учун ҳам модел бир саҳифали катта матн билан ишлаётганида, тахминан учинчи хатбошининг ўрталарига келиб, бошида нима бўлганини “унутиб қўярди”. Aммо Трансформер қудратли — бир вақтнинг ўзида ҲAММA нарсага қарай олади, янада қойилмақом натижалар бераётганининг сабаби ҳам шу.

Қисқача маълумот: GPT-1 2018 йилда пайдо бўлди ва нейротармоқ орқали матнларни яратиш учун каттароқ ҳажм ва самарадорликка эга Трансформер архитектурасидан фойдаланиш мумкинлигини исботлади. Яъни келажакда тил моделларининг ҳажми ва мураккаблигини ошириш учун катта захира яратилди.

(Давоми бу ерда)

Изоҳ қолдириш учун сайтда рўйхатдан ўтинг

Кириш

Ижтимоий тармоқлар орқали киринг

FacebookTwitter